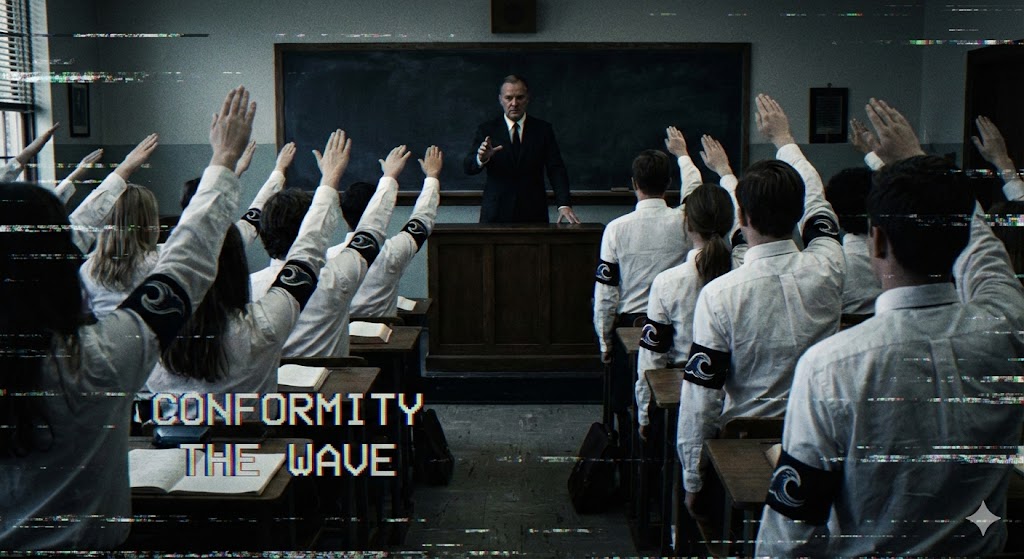

Binlerce yıldır insanlığın adalet ve hakikat anlayışı tek bir temel üzerine kuruluydu: “Gözümle gördüm, kulağımla duydum.”

Bir suçun videosu varsa, o kişi suçludur. Bir politikacının ses kaydı varsa, o sözleri söylemiştir. Görüntü ve ses, gerçeğin nihai kanıtıydı. Ancak Generative AI (Üretken Yapay Zeka) devrimiyle birlikte, bu temel kolon yıkıldı.

Artık ekranınızda gördüğünüz, çok sevdiğiniz bir ünlünün videosu, aslında hiç var olmamış olabilir. Telefondaki annenizin sesi, bir dolandırıcının klavyesinden çıkan metinlerin yapay zeka tarafından seslendirilmiş hali olabilir.

Hoş geldiniz, Sentetik Gerçeklik çağına. Burası, gerçeğin sadece “bir seçenek” olduğu, kanıtın ise bir “görüş açısı”na indirgendiği yer.

Post-Truth (Hakikat Sonrası) ve Gerçeğin Ölümü

Eskiden bir fotoğrafı manipüle etmek (Photoshop) uzmanlık ve saatler gerektirirdi. Bugün ise herhangi bir genç, saniyeler içinde yüz değiştirme (Face Swap) uygulamalarıyla kusursuz sahtecilikler yapabiliyor.

Sora veya Runway gibi yapay zeka modelleri, metinden hiper-gerçekçi videolar üretebiliyor. Bu teknoloji, Hollywood stüdyolarından çıkıp herkesin cebine girdiğinde ne olur?

Cevap basit: Gerçeklik enflasyonu. Ortada o kadar çok sahte içerik var ki, gerçeğin değeri sıfırlanıyor. Artık bir videoya bakıp “Bu gerçek mi?” diye sormuyoruz; “Bu ne kadar iyi yapılmış bir fake?” diye soruyoruz. Şüphe, varsayılan (default) ruh halimiz haline geldi.

[Link: Simülasyon Teorisi: Gerçeklik Bir Kod Hatası mı?]

Yalancının Kazancı (The Liar’s Dividend)

Deepfake teknolojisinin en tehlikeli yan etkisi, sadece sahte videolar üretmesi değildir. Asıl tehlike, gerçek videoların da inkar edilebilir hale gelmesidir.

Siyaset biliminde buna “Yalancının Kazancı” denir. Bir politikacı veya CEO yolsuzluk yaparken yakalansa ve %100 gerçek bir videosu ortaya çıksa bile, artık çok kolay bir savunma mekanizması var: “Bu bir Deepfake. Rakiplerim yapay zeka ile bana kumpas kurdu.”

Toplumun zihnine “her şey sahte olabilir” tohumu bir kez ekildiğinde, artık kimseyi hiçbir şeyle suçlayamazsınız. Gerçek kanıtlar da “şüpheli” kutusuna atılır. Hakikat, gürültü içinde kaybolur.

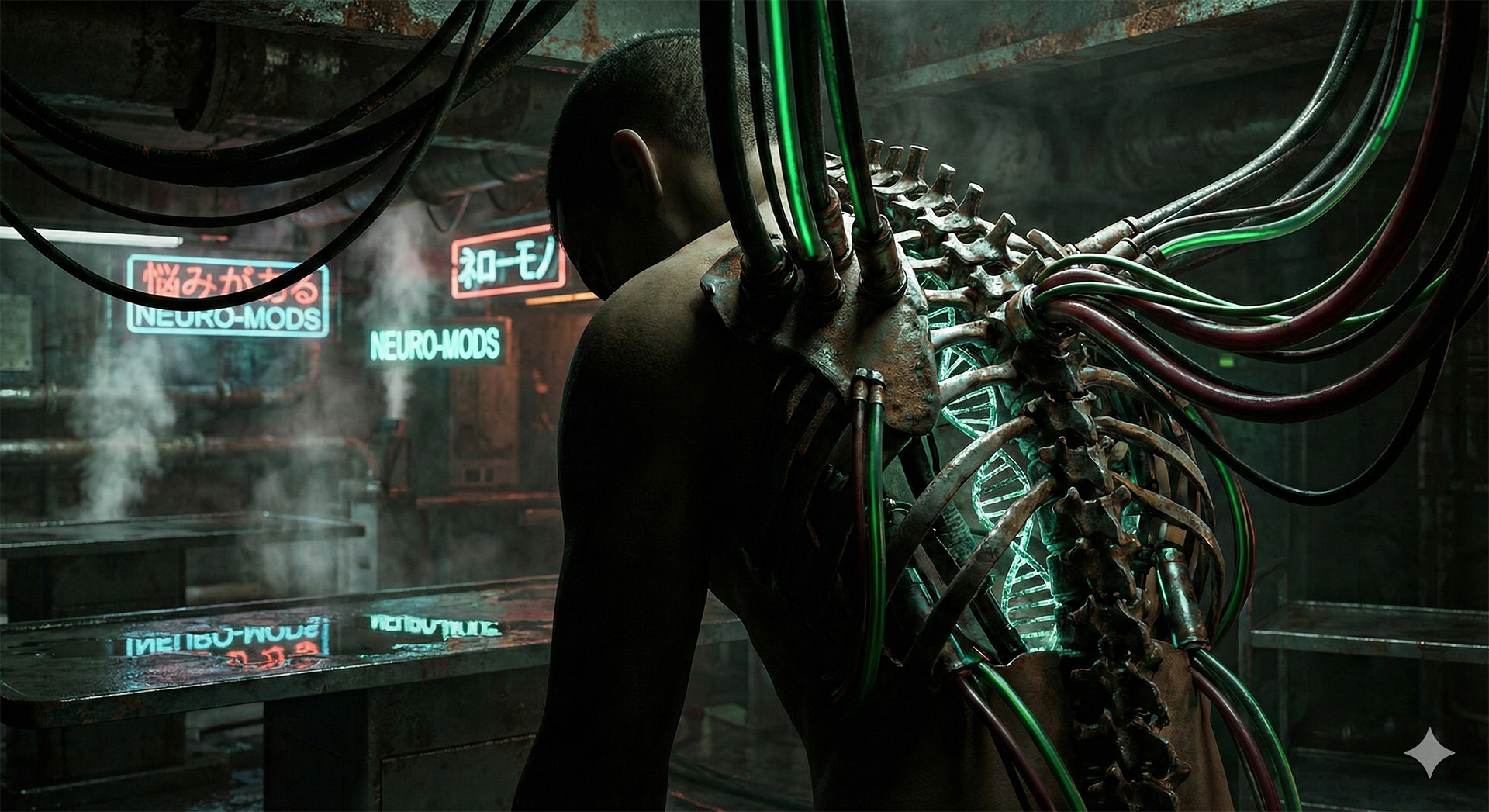

Ses Klonlama: En Sinsi Tehlike

Görüntüdeki hataları (fazla parmaklar, garip göz kırpmalar) bazen fark edebilirsiniz. Ancak ses konusunda beynimiz çok daha savunmasızdır.

Sadece 3 saniyelik bir ses örneğiyle, bir kişinin sesini klonlamak artık mümkün.

- Dolandırıcılık: Annenizin sesiyle sizi arayıp “Kaza yaptım, acil para lazım” diyen bir AI.

- Şirket Soygunları: CEO’nun sesiyle finans müdürünü arayıp “Acil şu hesaba para aktar” diyen bir bot.

Siber güvenlikte “Sıfır Güven” (Zero Trust) ilkesi tam da bu yüzden hayati önem taşıyor. Artık duyduğunuz sese bile güvenemezsiniz, mutlaka ikinci bir kanaldan doğrulama yapmalısınız.

[Link: Sıfır Güven (Zero Trust): Dijital Kalenin Surları Yıkıldı mı?]

Hukukun Çöküşü: Kanıt Artık Yok

Mahkemeler “makul şüphenin ötesinde” kanıt arar. Peki, bir cinayet davasında güvenlik kamerası kayıtlarının AI ile üretilmediğini kim kanıtlayacak?

Adli bilişim uzmanları şu an Deepfake’leri tespit edebiliyor (kalp atışına bağlı mikro renk değişimleri vb.). Ancak yapay zeka da kendini geliştiriyor. Bu bir kedi-fare oyunu. Yakında, bir videonun sahte olduğunu kanıtlamak, imkansız hale gelebilir.

Bu senaryoda hukuk sistemi tıkanır.

- Boşanma davalarında sahte aldatma kasetleri.

- Şirket davalarında sahte itiraf kayıtları.

- Uluslararası krizlerde sahte savaş suçları videoları.

Sosyal Mühendislik ve İtibar Suikastı

Bir sabah uyanıyorsunuz ve sosyal medyada, hiç yapmadığınız iğrenç bir şeyi yaparken çekilmiş videonuz viral olmuş. Siz “Bu ben değilim!” diye bağırana kadar milyonlarca insan o videoyu izledi, işinizden atıldınız, aileniz dağıldı.

Aylar sonra videonun sahte olduğu kanıtlanabilir. Ama kimin umurunda? İtibar bir kez kirlendiğinde, lekesi asla tam olarak çıkmaz. Sentetik gerçeklik, siber zorbalığı (cyberbullying) nükleer bir silaha dönüştürür. Herkes, herkesin hayatını mahvedebilir.

Sonuç: Gözlerinizi Kapatın, Şifrelemeyi Açın

Peki, bu distopyadan çıkış var mı? Teknik çözüm, Kriptografik Doğrulama (C2PA standartları) olabilir. Kameraların çektiği her kareyi, çekildiği anda blokzincir benzeri bir teknolojiyle dijital olarak imzalaması ve “bu görüntü orijinaldir” damgası vurması gerekebilir.

Ancak bu teknoloji yaygınlaşana kadar, tek savunmamız sağlıklı paranoyadır. Sentetik gerçeklik çağında, “Görmek inanmaktır” atasözü artık geçerli değildir. Yeni kural şudur: “Görüyorsan, iki kere şüphe et.”

Artık dijital dünyada hiçbir şey göründüğü gibi değil. Hatta bu okuduğunuz yazıyı bir insan mı yazdı, yoksa bir yapay zeka mı? Emin olabilir misiniz?

[Link: Kontrol İllüzyonu: Yapay Süper Zeka (ASI) İnsanlığın Son İcadı mı Olacak?]

❓ Sıkça Sorulan Sorular (SSS)

1. Bir videonun Deepfake olduğunu nasıl anlarım? Göz kırpma düzensizlikleri, dudak senkronizasyonu hataları, gölgelerin uyumsuzluğu ve cilt dokusundaki aşırı pürüzsüzlük ipucu verebilir. Ancak teknoloji geliştikçe bunları çıplak gözle anlamak imkansızlaşıyor.

2. Deepfake yapmak yasal mı? Çoğu ülkede hala gri bir alan. Ancak rıza dışı müstehcen içerik üretmek veya dolandırıcılık amacıyla kullanmak suç kapsamına alınmaya başlandı. Yine de yasalar teknolojinin çok gerisinde.

3. Kendimi ses klonlamadan nasıl korurum? Ailenizle aranızda bir “güvenlik kelimesi” (safe word) belirleyin. Eğer telefonda şüpheli veya acil bir durumla karşılaşırsanız, o kelimeyi sorun. AI henüz bu tür bağlamsal şifreleri bilemez.

Dış Link Önerisi: MIT Media Lab – Detect Fakes