Bilim tarihi boyunca insanlığın en büyük gururu “anlamak” oldu. Bir buhar makinesinin nasıl çalıştığını biliyorduk; çünkü dişlileri biz koymuştuk. Bir bilgisayar programının neden hata verdiğini bulabiliyorduk; çünkü if-else satırlarını biz yazmıştık.

Ancak son 10 yılda, bu “Aydınlanma Çağı” sessizce sona erdi ve yerini “Büyü Çağı”na bıraktı. Artık çalıştırdığımız, sonuç aldığımız ama nasıl düşündüğünü bilmediğimiz sistemler inşa ediyoruz.

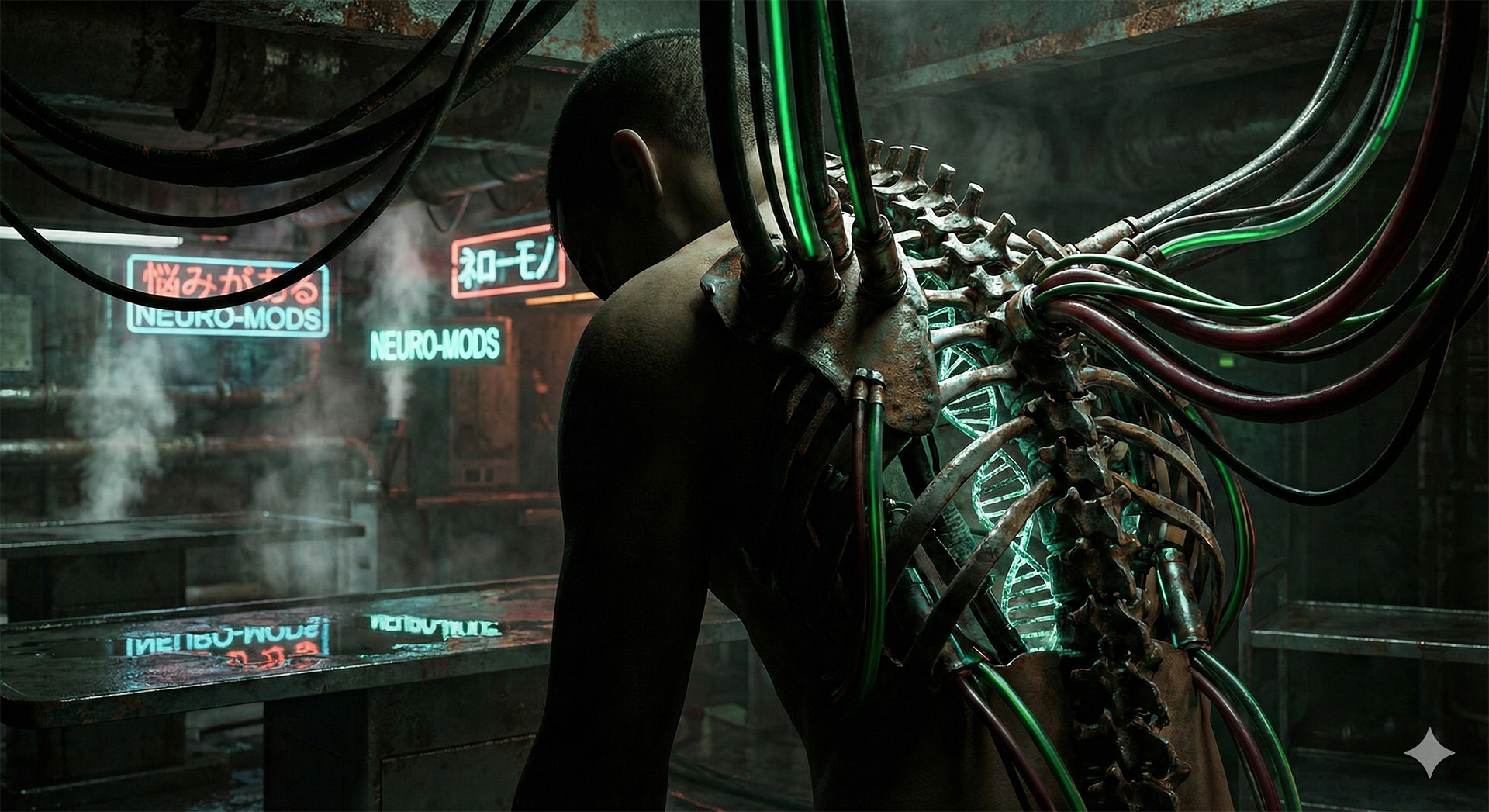

Buna Kara Kutu (Black Box) Paradoksu deniyor. Girdiyi (Input) veriyoruz. Çıktıyı (Output) alıyoruz. Ama arada, o “Gizli Katmanlar”da (Hidden Layers) neler olup bittiği hakkında yaratıcılarının bile en ufak bir fikri yok.

Tanrı, yarattığı kulun zihnini okuyamıyorsa, o hala Tanrı mıdır?

Hamle 37: Makinenin “Sezgisi”nin Doğduğu An

Kara Kutu probleminin en ikonik anı, 2016 yılında yaşandı. Google DeepMind’ın geliştirdiği AlphaGo, dünya Go şampiyonu Lee Sedol ile karşılaşıyordu.

Maçın ikinci oyununda, AlphaGo insanlık tarihinde görülmemiş bir hamle yaptı: Hamle 37. Bu hamle o kadar garipti ki, yorumcular bilgisayarın bozulduğunu sandı. Lee Sedol donup kaldı. Hiçbir insan Go hocası böyle bir hamle öğretmemişti. AlphaGo maçı kazandı.

Mühendisler daha sonra loglara baktığında şok oldular. AlphaGo, bu hamleyi bir veritabanından çekmemişti. Milyarlarca olasılığı hesaplayıp, insan mantığının kavrayamayacağı, tamamen “yabancı” (alien) bir strateji geliştirmişti.

İşte o an fark ettik: O sadece hesaplamıyordu. O, bizim anlamadığımız bir şekilde “düşünüyordu”.

[Link: Singularity Ufku: Kod Bilince Dönüştüğünde İnsanlığa Ne Olacak?]

Nöral Ağların Kaosu: Neden Kodları Okuyamıyoruz?

Geleneksel yazılım, bir yemek tarifi gibidir. “Yumurta kır, çırp, pişir.” Her adım açıktır. Ancak Derin Öğrenme (Deep Learning) modelleri, insan beynini taklit eden milyarlarca “nöron” ve “sinaps” bağlantısından oluşur.

GPT-4 gibi bir modele bir soru sorduğunuzda, bilgi tek bir satırda saklanmaz. Bilgi, trilyonlarca parametreye dağılmış sayısal ağırlıklar (weights) halindedir. Bir mühendisin bu kodu açıp okuması, bir nörocerrahın beyninizi açıp “Hah, çocukluk anısı şuradaki nöronun içinde” demesi kadar imkansızdır.

Sistemin içi, matematiksel bir çorbadır. Ve bu çorba o kadar karmaşıktır ki, neden “A” sonucunu değil de “B” sonucunu verdiğini matematiksel olarak geriye dönük izlemek (reverse engineer) imkansıza yakındır.

Açıklanamayanın Tehlikesi: “Bilmiyorum, Sadece Güven”

Eğer bir yapay zeka Netflix’te size yanlış film önerirse, bu bir sorun değildir. Ama ya bir Otonom Araç, yoldaki beyaz tırı “bulut” sandığı için frene basmazsa? (Tesla kazalarında yaşandığı gibi). Ya bir Tıbbi AI, röntgen filmindeki görünmez bir lekeye bakıp “Kanser” derse ve doktorlar orada hiçbir şey göremezse?

Sorun şu: AI haklı olabilir. Doktorların göremediği bir şeyi görüyor olabilir. Ama “neden” kanser olduğunu açıklayamazsa, doktor o hastayı kemoterapiye sokmalı mı?

Burada korkutucu bir yol ayrımına giriyoruz:

- Doğruluk (Accuracy): Kara Kutu modelleri çok daha başarılıdır ama açıklanamaz.

- Açıklanabilirlik (Explainability): Basit modeller açıklanabilir ama aptaldır.

İnsanlık yavaş yavaş anlamayı bırakıp, sadece güvenmeyi seçiyor. Bu, teknolojiyi bilime değil, bir nevi “dine” dönüştürüyor.

Algoritmik Önyargı: Kutunun İçindeki Hayaletler

Kara kutuların bir diğer tehlikesi, içlerinde bizim toplumsal önyargılarımızı saklamalarıdır. Amazon, işe alım için geliştirdiği bir yapay zekayı kapatmak zorunda kaldı. Neden? Çünkü yapay zeka, kadın adayları eliyordu.

Kimse ona “Kadınları ele” diye bir kod yazmamıştı. Ama yapay zeka, son 10 yılın işe alım verilerini incelemiş ve (sektördeki erkek egemenliği yüzünden) “Erkek olmak başarı kriteridir” sonucunu kendi kendine çıkarmıştı.

Kutu kapalı olduğu için, bu önyargıyı fark etmek aylar sürdü. Eğer bu bir kredi verme algoritması veya suçlu profilleme sistemi olsaydı, insanların hayatını “sessizce” kaydırabilirdi.

[Link: Sentetik Gerçeklik: Deepfake Çağında “Gözümle Gördüm” Demenin Sonu]

XAI: Kutuyu Açma Çabası

Bilim dünyası şu an XAI (Explainable AI – Açıklanabilir Yapay Zeka) üzerinde çalışıyor. Amaç, yapay zekanın verdiği kararın “haritasını” çıkarmak. “Bunu seçtim çünkü şu pikselde tümör gördüm” dedirtmek.

Ancak bazı uzmanlar bunun boşuna bir çaba olduğunu düşünüyor. Geoffrey Hinton (Yapay Zekanın vaftiz babası) şöyle diyor: “İnsanlar da kararlarını nasıl verdiklerini açıklayamazlar. Bir şeyi neden sevdiğinizi mantıklı bir şekilde anlatabilir misiniz? Yoksa sadece hisseder misiniz?”

Belki de gerçek zeka, tanımı gereği bir kara kutudur.

Sonuç: Yabancı Bir Zeka ile Yaşamak

Bizler, uzaylıların gökyüzünden inmesini beklerken, onları kendi laboratuvarlarımızda, silikon ve elektrikten inşa ettik. Artık onlarla konuşabiliyoruz, ama onları tam olarak anlayamıyoruz.

Kara Kutu Paradoksu, mühendisliğin bittiği ve felsefenin başladığı yerdir. Gelecekte, hayatımızla ilgili en kritik kararları (işe alınma, kredi onayı, tıbbi teşhis, hatta savaş ilanı) bu kutular verecek. Ve biz, o pürüzsüz siyah yüzeye bakıp, sadece “Umarım ne yaptığını biliyordur” diyebileceğiz.

❓ Sıkça Sorulan Sorular (SSS)

1. Yazılımcılar yazdıkları kodu nasıl bilmezler? Yazılımcılar “öğrenme mimarisini” (okul binasını) inşa ederler. Ama yapay zeka verileri işleyerek kendi bağlantılarını (bilgiyi) kendi oluşturur. Öğretmen, öğrencinin beynindeki nöronların nasıl bağlandığını bilemez.

2. Açıklanabilir Yapay Zeka (XAI) mümkün mü? Kısmen evet. Kararın hangi verilere dayandığını gösteren “ısı haritaları” (heatmaps) kullanılıyor. Ama bu hala tam bir “neden-sonuç” ilişkisi değil, sadece bir ipucudur.

3. Bu durum tehlikeli mi? Kritik sistemlerde (sağlık, savunma, havacılık) evet. Hatanın nedenini bulamazsanız, onu düzeltemezsiniz. Bu yüzden bu alanlarda hala “açıklanabilir” ama daha az zeki sistemler veya insan denetimi (Human-in-the-loop) tercih ediliyor.

Dış Link Önerisi: Netflix – AlphaGo Documentary